Q-learning의 기본 식을 이끌어 내기 위해 한 '믿음'을 살펴보자.

1. 먼저 나는 s에 있고

2. action a를 취하면 s'으로 이동하며 reward r을 받는다.

여기서, s'에 Q가 있다고 믿자.

s'에 Q가 있다고 믿자는 것의 의미는 아마도

(s에서 a를 취해 변한 state) s'에서 어떤 action을 취해서 받을 reward를 알고 있다고 가정하자는 것인 것 같다.

(특정 action이라기 보다 그 어떤 action에 대한 reward라도)

이제 Q(s, a)를 Q(s', a')을 이용해 나타내보면,

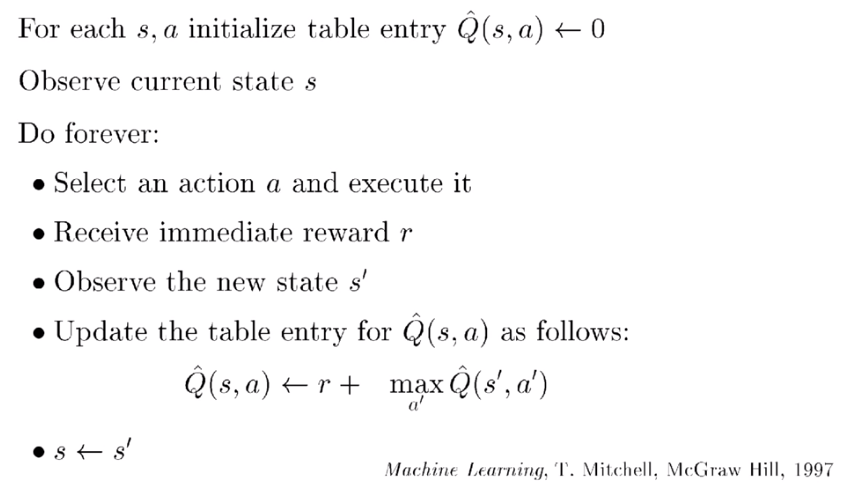

Q(s, a) = r + max(a') Q(s', a')

r은 s에서 a를 취해 즉각적으로 얻은 reward이며

max(a') Q(s', a')은 그 이후 단계에서 얻을 최대 reward를 뜻한다.

즉 위의 '믿음'을 통해 '그 이후 단계에서 얻을 최대 reward'를 알 수 있다'는 의미 흐름이다.

이 계산을 계속해나가다보면 결국 Q값이 학습된다.

('믿음'에서 점점 실제로 그렇게 되감!)

마지막으로 이 내용을 알고리즘 형태로 정리한 것은 다음과 같다.

Reference: Sung Kim 모두를 위한 RL강좌 정리

작성일: 2018. 10. 3.

'머신러닝, 딥러닝 > Reinforcement Learning' 카테고리의 다른 글

| DQN (0) | 2022.03.12 |

|---|---|

| 강화학습 복습 자료 5: Stochastic World (0) | 2022.03.12 |

| 강화학습 복습 자료 4: Discounted future reward (0) | 2022.03.12 |

| 강화학습 복습 자료 3: Exploit & Exploration (0) | 2022.03.12 |

| 강화학습 복습 자료 1: Concept of RL (0) | 2022.03.12 |

댓글